10.496 Shader-ALUs mit rund 35 TFLOPS Rechenleistung sowie 24 GiByte GDDR6X-Speicher mit beinahe 1 TByte/s Datendurchsatz: Die Geforce RTX 3090 ist nicht nur technisch ein dicker Fisch, sondern auch in allen anderen Belangen. Was die 350-Watt-Grafikkarte mit einem Kampfgewicht von satten 2,16 Kilogramm in Spielen und beim Rendering leistet, erfahren Sie im Test der Geforce RTX 3090 Founders Edition.

Am heutigen 24. September hat Nvidias neues Schlachtschiff seine Jungfernfahrt, die Geforce RTX 3090 Founders Edition. Eines können Sie uns glauben: Von dem Moment an, in dem Sie die Packung öffnen und dieses Monstrum von Grafikkarte erblicken, verfliegt jeder Zweifel, ob sich die gerade versenkten 1.500 Euro (wenn die Karten denn verfügbar sind, siehe Alternate) amortisieren. Die RTX 3090 FE ist zweifellos die größte und schwerste Single-GPU-Grafikkarte, welche PCGH je im Testlabor hatte – und sie ist außerdem die schnellste. Zeit, der „Big Ferocious GPU“ (BFGPU) genauer auf den Zahn zu fühlen und nach der Achillesferse zu suchen.

ASUS TUF Gaming GeForce RTX 3090 OC, TUF-RTX3090-O24G-GAMING, 24GB GDDR6X, 2x HDMI, 3x DP (90YV0FD1-M0NM00)Anschlüsse: 2x HDMI 2.1, 3x DisplayPort 1.4a

Nvidia platziert die Geforce RTX 3090 in Sachen Preis und Leistung ungefähr dort, wo seit Jahren Modelle der „Titan“-Reihe auf anspruchsvolle Kundschaft warten. Alleinstellungsmerkmale der Titan-Grafikkarten sind ihre exorbitante Speicherkapazität sowie spezielle Software-Features, um eine höhere Leistung in (semi-)professionellen Anwendungen wie CAD und Rendering zu erzielen. Mit der Geforce RTX 3090 vollzieht Nvidia eine kleine Änderung in diesem Bereich: Die GA102-Speerspitze muss ohne CAD-Beschleunigung auskommen, kostet im Vergleich mit der dazu fähigen Titan RTX jedoch knapp die Hälfte. Die Kernklientel, so Nvidia, seien Kreativschaffende, bei denen die enorme Speicherkapazität und Rechenleistung fühlbare Erleichterungen ihrer Arbeit bringe. Hochkomplexe Modelle, riesige Texturen, Raytracing-Beleuchtung, all das stemmt die Geforce RTX 3090 schneller als jede andere Grafikkarte. Selbstverständlich prüfen wir diese Versprechen anhand einiger Vergleichskarten, doch auch das Gaming kommt nicht zu kurz. Wie von PCGH gewohnt, haben wir abseits der Standardtests auch einige Extrem-Benchmarks vorbereitet, um die RTX 3090 angemessen zu fordern.

Spezifikationen der RTX 3090, RTX 3080 und RTX 3070

Zur Erinnerung: Die RTX-30-Reihe mit dem Architekturnamen Ampere besteht anfangs aus drei Grafikkarten: der Geforce RTX 3090, der Geforce RTX 3080 und der Geforce RTX 3070. Den Anfang machte am 17. September das offizielle Geforce-Gaming-Flaggschiff RTX 3080 – und war binnen Minuten ausverkauft. Nun ist die Geforce RTX 3090 an der Reihe, welche im neuen Nvidia-Portfolio die Position der „Titan“ einnimmt. Das vorläufige Finale startet am 15. Oktober mit der Geforce RTX 3070.

Bei Ampere handelt es sich um Nvidias zweite RTX-Generation. Die erste erschien vor genau zwei Jahren als Geforce RTX 20 (Codename Turing) mit dem Versprechen, „Grafik neu erfunden“ zu haben. Im Fokus der Architektur stand nicht mehr bloß eine Leistungssteigerung – wie noch beim Vorgänger Pascal -, sondern ein Quantensprung auf dem Weg zum Fotorealismus: Hybrides Raytracing statt Rasterisierung. Zu diesem Zweck implementierte Nvidia als erster GPU-Hersteller spezialisierte Hardware-Einheiten, welche die hochkomplexen Berechnungen bei echtzeittauglichen Bildraten stemmen können. Die Basis dafür schafften die Kalifornier mit vielen anderen Unternehmen, darunter AMD und Intel, im Rahmen von DirectX: Die Microsoft-Schnittstellensammlung beinhaltet seit zwei Jahren den Unterpunkt DXR – DirectX Raytracing – und schafft somit die nötige Software-Umgebung, um standardisiert mit der Hardware zu sprechen. Wie Letztere mit den Befehlen umgeht, ist hingegen nicht vorgeschrieben. Grafikchips können Raytracing-Renderanforderungen auf ihre generalisierten Rechenwerke abwälzen, diese mit entsprechenden Spezialfunktionen ausstatten oder eigenständige Fixed-Function-Kerne aus der Taufe heben. Letzteres tat Nvidia bei Turing – alle Informationen finden Sie im ausführlichen Technik-Dossier.

RTX 3090: Mehr Ampere geht (noch) nicht

Die Geforce RTX 3090 und RTX 3080 basieren beide auf dem neuen GA102, Nvidias bislang fortschrittlichstem Gaming-Prozessor. Der Chip beherbergt im „Full-Fat“-Vollausbau 10.752 Shader-ALUs – ein Wert, den man erst einmal sacken lassen muss. Möglich wird dies durch eine gegenüber Turing verfeinerte Fertigung, welche im Gegensatz zu den vorherigen Top-Chips nicht aus dem Hause TSMC stammt. Stattdessen einigte sich Nvidia mit Samsung, deren 8LPP-Verfahren zwar ohne neuartige EUV-Belichtung auskommt, dafür aber mutmaßlich eine gute Ausbeute und vor allem ein gutes Preisleistungsverhältnis aufweist. Nvidia verwendet einen angepassten Prozess mit der Bezeichnung 8N.

Speicherdurchsatz nahe der Terabyte-Marke

Um die gestiegenen Bandbreitenanforderungen zu erfüllen, taten sich Nvidia und Speicherspezialist Micron zusammen. Herausgekommen ist GDDR6X-DRAM, eine Weiterentwicklung von GDDR6, welche bis zu 21 Gigatransfers pro Sekunde (GT/s) erreichen soll. Zum Vergleich: GDDR6 endet offiziell bei 16 GT/s. Möglich wird dies durch einen grundsätzlich alten, aber verfeinerten Eingriff bei der Signalübertragung, welche nun vier statt nur zwei Zustände kennt („PAM4“). Somit wird pro Takt die doppelte Menge an Information übertragen, wodurch sich der interne Takt senken und Energie sparen lässt, ohne dass die effektive Leistung sinkt.

MSI GeForce RTX 3090 Ventus 3X 24G OC, 24GB GDDR6X, HDMI, 3x DP (V388-002R)Anschlüsse: 1x HDMI 2.1, 3x DisplayPort 1.4a

Im Falle der Geforce RTX 3090 beträgt der Speichertakt „nur“ 19,5 GT/s, übersetzbar mit 9.750 MHz im Vergleich zu den bisher üblichen 14 GT/s respektive 7.000 MHz. Was am Ende zählt, ist das Produkt aus Interface-Breite und Takt. Hier schleust die RTX 3090 stolze 936 GByte/s umher und scheitert damit knapp an der magischen Grenze von 1 TByte/s – das schafft im Endkundenbereich nur AMDs Radeon VII. Wie Nvidia auf Nachfrage bestätigt, verfügt der GA102 über keine weiter verbesserte Speicherkompression, sondern zieht diesbezüglich mit Turing gleich. Vorherige Generationen wiesen hier stets neue Kniffe auf, um Daten verlustfrei zu packen und somit den Datenverkehr auf dem Speicherbus zu reduzieren. Hier dürfte einer der Gründe liegen, weshalb die rohe Transferrate gegenüber Turing (max. 672 GByte/s) so deutlich angehoben wurde – beim Wechsel vom Pascal- auf das Turing-Topmodell (Titan gegen Titan) waren es nur rund 23 Prozent.

In den folgenden Benchmarks richten sich alle Augen auf den Vergleich zwischen RTX 3080 und RTX 3090. Dabei wissenswert ist, dass die RTX 3090 bei nur 30 Watt höherem Energiebudget 14 zusätzliche Speicherbausteine sowie 14 Shader-Multiprozessoren mit Energie versorgen muss. Mit den von Nvidia angegebenen Taktraten weist die RTX 3090 knapp 20 Prozent mehr GPU-Leistung und eine um 23 Prozent höhere Speichertransferrate (bei +140 Prozent Kapazität) auf. Was davon in der Praxis in Leistung umgesetzt wird, sehen wir in den Benchmarks. In der folgenden Tabelle, welche von uns mehrfach geprüft und durchgerechnet wurde, fassen wir alle relevanten Leistungsdaten zusammen. Enthalten ist nicht nur die Geforce RTX 3090, sondern auch ihre beiden Geschwister mit den finalen Spezifikationen, sowie diverse ältere Modelle.

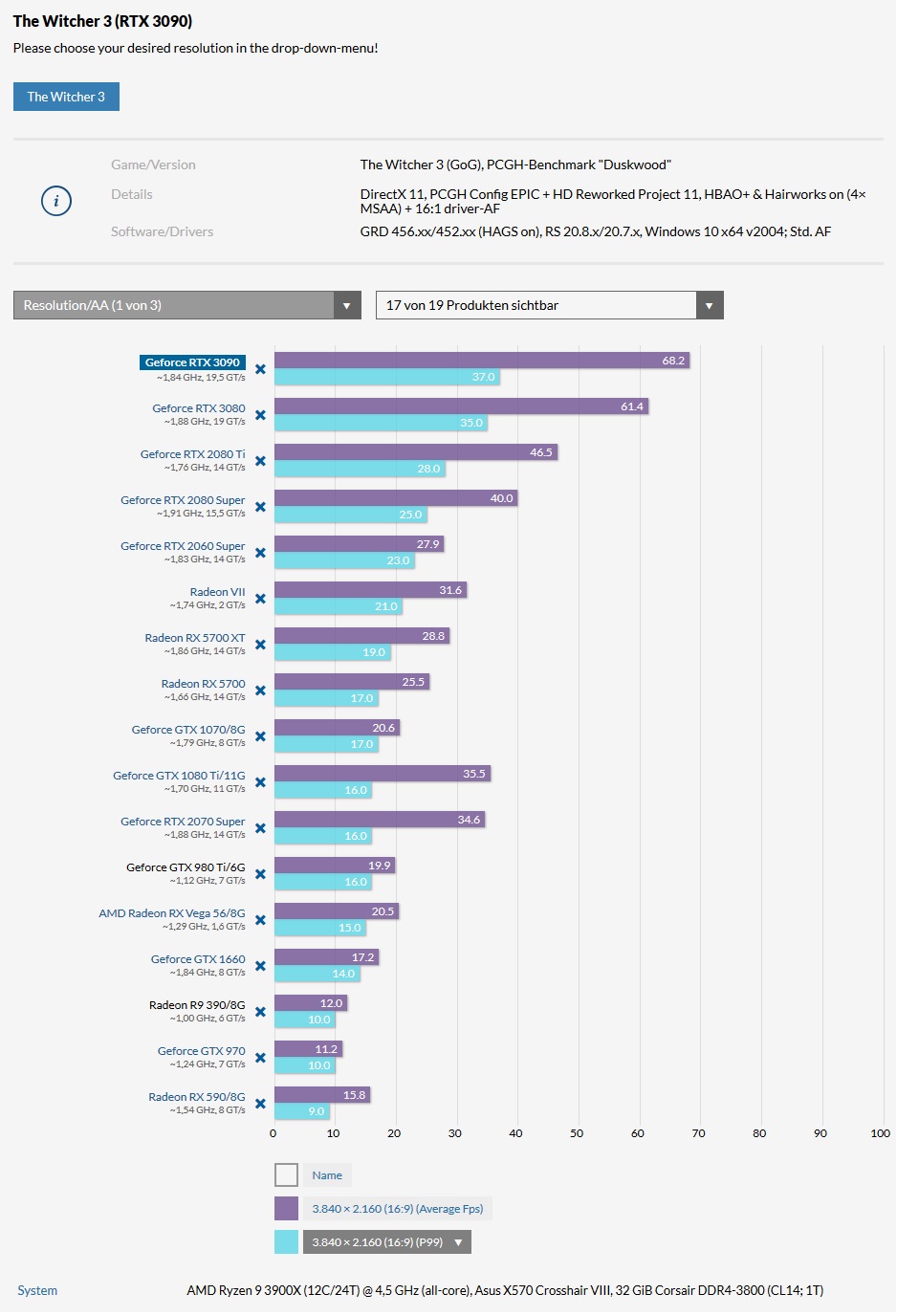

Geforce RTX 3090: Spiele-Benchmarks

Beginnen wir mit den Standard-Benchmarks, welche Teil des PCGH-Leistungsindex sind. Da wir es bei der Geforce RTX 3090 mit einer Enthusiasten-Grafikkarte zu tun haben, verzichten wir auf die anspruchslose Full-HD-Auflösung. Diese ist mit Renderboliden wie Ampere stets zu Teilen prozessorlimitiert und zeigt daher nicht das volle Potenzial dieser Grafikkarten. Falls sie sich für die 1080p-Ergebnisse interessieren, werfen Sie am besten einen Blick in die kommende PCGH 11/2020, denn dort sind die Full-HD-Werte als Teil des Leistungsindex aufgeführt. Die komplette Spiele-Liste:

Leistung beim Raytracing

Vor wenigen Wochen haben wir die Arbeiten am Raytracing-Index 1.0 abgeschlossen und Ihnen die ersten Ergebnisse im Rahmen der Spezialtests zur Geforce RTX 3080 präsentiert. Selbstverständlich muss sich auch die RTX 3090 bei der Strahlenberechnung beweisen. Der RT-Index beinhaltet die folgenden fünf Spiele mit überdurchschnittlich anspruchsvollen RT(X)-Effekten: Control, Deliver Us The Moon, Minecraft RTX, Metro Exodus und Wolfenstein Youngblood. Unsere Wahl fiel auf gerade diese Mischung, weil wir damit das volle Spektrum derzeitiger Raytracing-Spiele abbilden können. Da sind die sehenswerten Eigenentwicklungen und andererseits die neuerdings grundsätzlich RT-fähige Unreal Engine 4, welche in zahlreichen Produktionen zum Einsatz kommt. Unsere Wahl fiel auch auf diese fünf Titel, da sie alle über DLSS-Support verfügen. Dabei handelt es sich um ein KI-gestütztes, besonders hochwertiges Upscaling, das Nvidia seinen RTX-Karten mit auf den Weg gibt, um die „Strahlenbelastung“ zu reduzieren. Im Gegensatz zu Raytracing ist DLSS absolut proprietär, bleibt ergo Geforce-Nutzern vorbehalten. Die beachtlichen Performance-Gewinne entstehen einzig und allein durch eine interne Reduktion der Auflösung, welche jedoch clever ausgeglichen wird – alle Informationen finden Sie im Artikel DLSS 2.0 im Härtetest.

Nicht unerwähnt bleiben sollte, dass wir es hier nicht darauf anlegen, möglichst alle Grafikkarten mit maximaler Qualität niederzustrecken (treue Leser wissen, dass wir diese Tendenz haben). Stattdessen haben wir uns für diverse Vernunfteinstellungen entschieden, anstatt alle Regler zu maximieren. Da wäre das äußerst anspruchsvolle Minecraft RTX (Beta), das bei jedem Start die Spielwelt nur mit acht sogenannten RT Chunks darstellt. Der Maximalwert, welcher eine deutlich höhere Darstellungsdistanz bringt, liegt bei 24. Wir testen aus Gründen der Spielbarkeit mit dem Mittelwert von 16 Chunks. Bei Metro Exodus verzichten wir – wie im normalen GPU-Leistungsindex – auf die „Extreme“-Detailstufe und belassen’s bei Ultra, das Raytracing steht jedoch auf Ultra. Und beim Speicherfresser Wolfenstein Youngblood sehen wir davon ab, das Bild-Streaming auf die Maximalstufe zu setzen. Täten wir das, bräuchte man schon in Full HD die 10 GiByte einer Geforce RTX 3080. Doch genug der Vorrede, kommen wir nun zu den Ergebnissen.

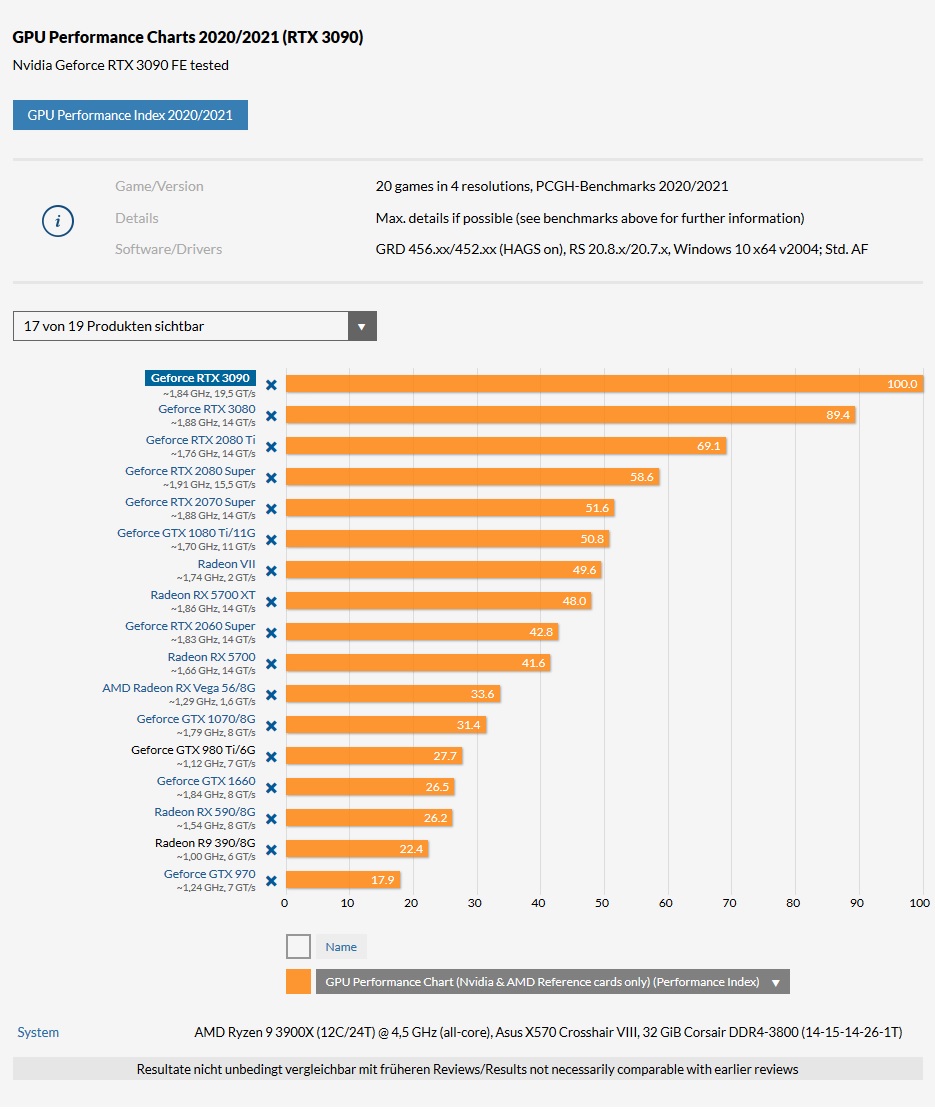

Geforce RTX 3090: Fazit

Der König ist tot, lang lebe der König: Die Amtszeit der Geforce RTX 3080 als Herrscherin über den PCGH-Leistungsindex währte nicht lange, war jedoch von langer Hand geplant. Blickt man auf die Superlativen, welche die Geforce RTX 3090 auf dem Papier mitbringt, und vergleicht sie mit dem, was davon praktisch ankommt, darf man Nvidia Kalkül vorwerfen. Als Gesamtpaket aus Preis und Leistung hinterlässt die vorausgeschickte Geforce RTX 3080 einen wesentlich besseren Eindruck und brannte sich bei der Spielerschaft als begehrenswertes Aufrüstobjekt ein. Der für viele Interessenten frustrierende Launch, an dem die erste Grafikkarten-Charge in Rekordzeit ausverkauft war, verwundert nur bedingt, denn insgesamt macht Nvidia mit der RTX 3080 vieles richtig.

Wozu also die Geforce RTX 3090? Legt man die nackten Zahlen auf den Tisch, stimmen die Verhältnisse hinten und vorne nicht: 114 Prozent Aufpreis für durchschnittlich 12 Prozent mehr Gaming-Leistung (14 Prozent beim Raytracing). Diese einseitige Betrachtung wird dem Produkt Geforce RTX 3090 Founders Edition jedoch nicht gerecht. Da wäre die offizielle Positionierung zu nennen, gemäß derer die RTX 3090 kein reines Spielzeug ist, sondern sich vor allem an Kreativschaffende richtet. Was vor einigen Jahren noch mehr Vorwand als echter Grund war, lässt sich mittlerweile nicht mehr wegdiskutieren. Wer Design, Rendering und Videobearbeitung am heimischen Rechner betreibt, kann die zahlreichen Rechenwerke einer modernen Grafikkarte produktiv einsetzen, da die entsprechende Software dazu fähig ist. Je mehr Tera-FLOPS und Giga-Bytes, desto komfortabler das Arbeiten mit großen Modellen, Texturen und Daten und desto schneller lassen sich die Ergebnisse vorzeigen, anstelle minuten- oder gar stundenlang auf das fertige Bild zu warten. Einige Programme sind mittlerweile in der Lage, auch die spezialisierten Tensor- und RT-Kerne in Turing- und Ampere-Grafikkarten für signifikante Zeitgewinne einzuspannen – ein deutlicher Mehrwert für alle, die damit arbeiten. Die Frage, ob sich eine 1.500-Euro-Grafikkarte lohnt, stellt sich in solchen Fällen nur selten. Die Frage ist eher: Lohnt es sich da noch, in eine sündteure Quadro-Profi-Grafikkarte zu investieren? Die Antwort lautet (nur dann) ja, wenn Ausfallsicherheit, Support und spezielle CAD-Funktionen wichtig sind.